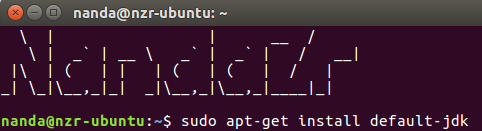

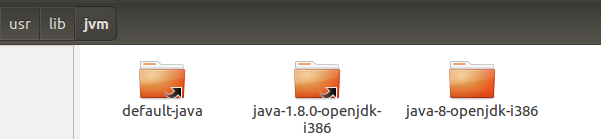

- Pertama, install java

$ sudo apt-get install default-jdk

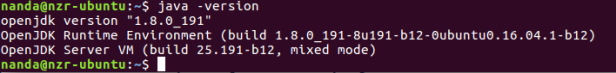

Cek apakah java telah terinstal di ubuntu anda

$ java -version

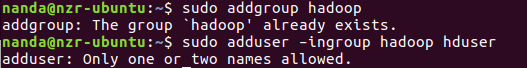

- Menambah Hadoop User

$ sudo addgroup hadoop

$ sudo adduser –ingroup hadoop hduser

Jika sebelumnya sudah dibuatkan user tersebut maka akan muncul tulisan The group ‘hadoop’ already exists. Memasukan user baru berserta password jika diminta

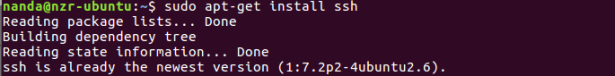

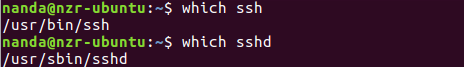

- Install SSH

sudo apt-get install ssh

untuk memastikan ssh telah terinstal gunakan perintah $ which ssh. Jika sudah terinstal maka akan muncul seperti ini: /usr/bin/ssh

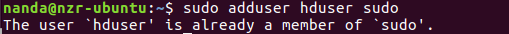

- Memberi hduser sudo permission

$ sudo adduser hduser sudo

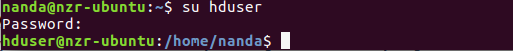

- Setup SSH Certificate

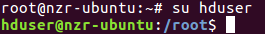

Sebelumnya masuk sebagai hduser. akan diminta password yang baru dibuat tadi

$ su hduser

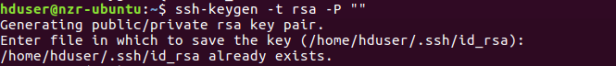

- Generate SSH key

$ ssh-keygen -t rsa -P “”

Langsung tekan enter. Setelah itu, masukkan perintah berikut:

$ cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

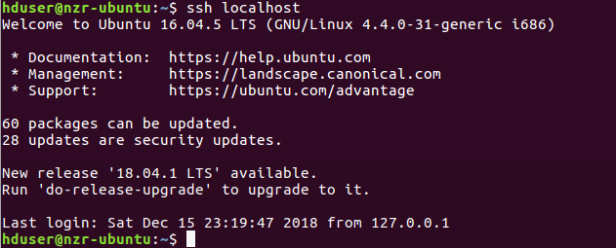

Cek apakah ssh berfungsi atau tidak.

$ ssh localhost

Disini sudah dilakukan setup SSH maka tampilan seperti diatas. Jika belum nanti akan ada pilihan (yes/no) ketik yes lalu enter.

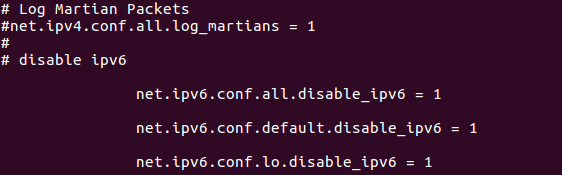

- Nonaktifkan IPV6

Nonaktifkan IPV6 terlebih dahulu karena ubuntu menggunakan IP 0.0.0.0 untuk konfigurasi Hadoop yang berbeda

$ nano /etc/sysctl.conf

Setelah terbuka text editornya, lalu masukkan kode berikut

# disable ipv6

net.ipv6.conf.all.disable_ipv6 = 1

net.ipv6.conf.default.disable_ipv6 = 1

net.ipv6.conf.lo.disable_ipv6 = 1

Kemudian simpan. Untuk mengeceknya bisa gunakan perintah berikut

$ cat /proc/sys/net/ipv6/conf/all/disable_ipv6

apabila muncul angka 0 maka IPV6 berhasil dinonaktifkan

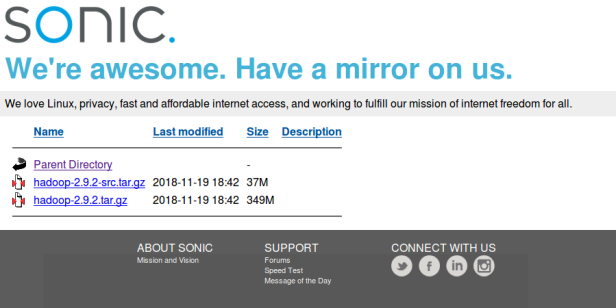

- Install hadoop

a. Download hadoop

Masuk sebagai hduser terlebih dahulu

Buka brower, lalu cek hadoop versi berapa yang ingin anda install

http://mirrors.sonic.net/apache/hadoop/common/

Pada tutor ini menggunakan hadoop-2.9.2

http://mirrors.sonic.net/apache/hadoop/common/hadoop-2.9.2/hadoop-2.9.2.tar.gz

untuk mendownloadnya copy paste link hadoop tersebut pada terminal:

$ wget http://mirrors.sonic.net/apache/hadoop/common/hadoop-2.9.2/hadoop-2.9.2.tar.gz

note: di dalam folder/direktori web tersebut ada beberapa file bernama hadoop. Pastikan pilihan yang tidak berakhiran -src dan pilih berukuran paling besar

b. Extract dan install hadoop

Setelah hadoop terdwnload, extract dengan perintah berikut

$ tar xvzf hadoop-2.9.2.tar.gz

Setelah berhasil diextract, masuk ke folder hadoop

$ cd hadoop-2.9.2

selanjutnya buat direktori dg perintah berikut

$ mkdir /usr/local/hadoop

kemudian pindahkan folder hadoop-2.9.2 tadi ke dalam /usr/local/

$ sudo mv hadoop-2.9.2 /usr/local/hadoop

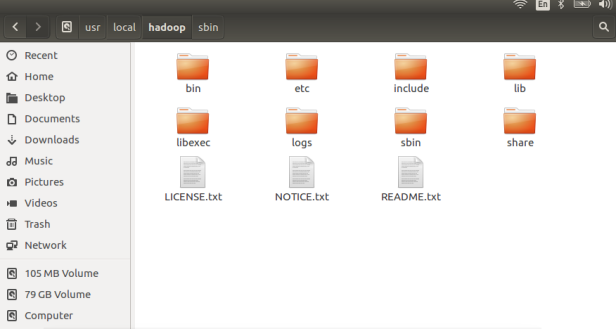

pastikan direktori/folder seperti gambar berikut

- Konfigurasi hadoop

Ubah owner file-file tersebut menjadi milik hduser

$ sudo chown -R hduser:hadoop /usr/local/hadoop

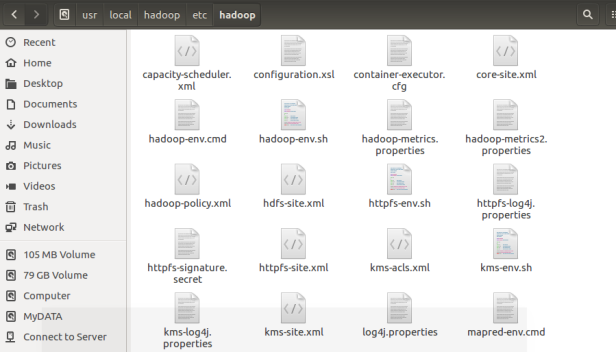

Berikut ini adalah file-file yang digunakan untuk konfigurasi single-node hadoop cluster:

> ~/.bashrc

> core-site.xml

> mapred-site.xml

> hdfs-site.xml

file-file tersebut bisa ditemukan pada direktori berikut:

$ cd /usr/local/hadoop/etc/hadoop

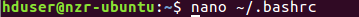

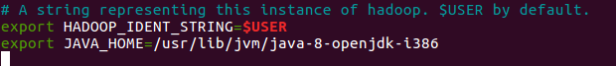

- Edit file ~/.bashrc

Gunakan perintah $ vim ~/.bashrc atau $ nano ~/.bashrc

kemudian copy kode berikut ini

#HADOOP VARIABLES START

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-i386

export HADOOP_INSTALL=/usr/local/hadoop

export PATH=$PATH:$HADOOP_INSTALL/bin

export PATH=$PATH:$HADOOP_INSTALL/sbin

export HADOOP_MAPRED_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_HOME=$HADOOP_INSTALL

export HADOOP_HDFS_HOME=$HADOOP_INSTALL

export YARN_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_INSTALL/lib/native

export HADOOP_OPTS=”-Djava.library.path=$HADOOP_INSTALL/lib”

#HADOOP VARIABLES END

note: pada baris kedua silahkan ganti tulisan berwarna merah, pastikan sesuai dengan versi java di PC anda. PC saya menggunakan java versi 8

Selanjutnya masukkan perintah ini

$ nano /usr/local/hadoop/etc/hadoop/hadoop-env.sh

Copy kode berikut lalu simpan

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-i386

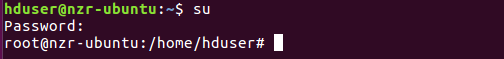

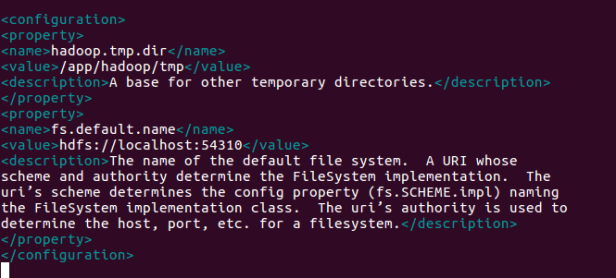

- Edit file core-site.xml

Sebaiknya gunakan superuser(root) untuk melakukan konfigurasi

$ su

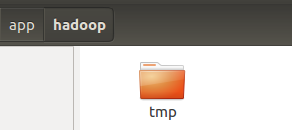

Masukkan perintah berikut

$ sudo mkdir -p /app/hadoop/tmp

perintah diatas berfungsi utk membuat folder baru dengan nama tmp. Di folder ini nanti akan disimpan file-file cache

$ sudo chown hduser:hadoop /app/hadoop/tmp

$ nano /usr/local/hadoop/etc/hadoop/core-site.xml

Copy kode berikut lalu simpan

<property>

<name>hadoop.tmp.dir</name>

<value>/app/hadoop/tmp</value>

<description>A base for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:54310</value>

<description>The name of the default file system. A URI whose

scheme and authority determine the FileSystem implementation. The

uri’s scheme determines the config property (fs.SCHEME.impl) naming

the FileSystem implementation class. The uri’s authority is used to

determine the host, port, etc. for a filesystem.</description>

</property>

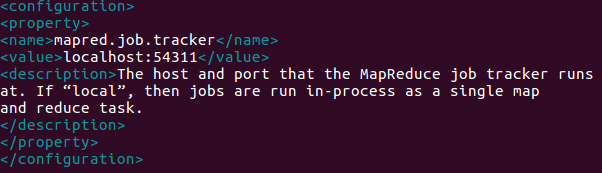

c. Edit file mapred-site.xml

Masukkan perintah berikut

$ cp /usr/local/hadoop/etc/hadoop/mapred-site.xml.template /usr/local/hadoop/etc/hadoop/mapred-site.xml

$ nano /usr/local/hadoop/etc/hadoop/mapred-site.xml

Copy kode berikut lalu simpan

<property>

<name>mapred.job.tracker</name>

<value>localhost:54311</value>

<description>The host and port that the MapReduce job tracker runs at. If “local”, then jobs are run in-process as a single mapand reduce task.

</description>

</property>

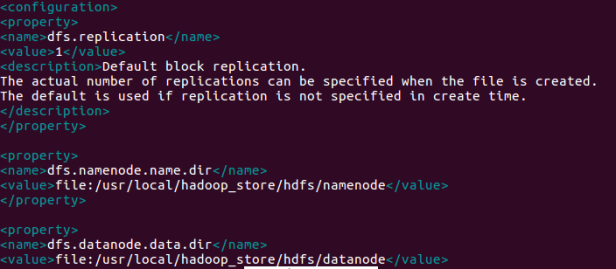

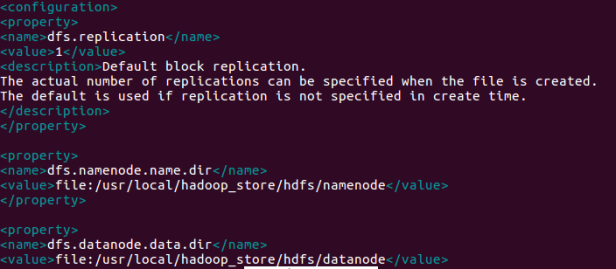

d. Edit file hdfs-site.xml

Masukkan perintah berikut

$ sudo mkdir -p /usr/local/hadoop_store/hdfs/namenode

$ sudo mkdir -p /usr/local/hadoop_store/hdfs/namenode

$ sudo chown -R hduser:hadoop /usr/local/hadoop_store

$ nano /usr/local/hadoop/etc/hadoop/hdfs-site.xml

Copy kode berikut lalu simpan

<property>

<name>dfs.replication</name>

<value>1</value>

<description>Default block replication.

The actual number of replications can be specified when the file is created.

The default is used if replication is not specified in create time.

</description>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop_store/hdfs/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop_store/hdfs/datanode</value>

</property>

Setelah konfigurasi selesai restart OS anda

- Selanjutnya lakukan Format Filesystem Hadoop

$ hadoop namenode -format

- Mulai Hadoop

Ganti user menjadi hduser: $ su hduser

Jadikan hduser sebagai owner hadoop

$ sudo chown -R hduser:hadoop /usr/local/hadoop/

Mulai

$ start-all.sh

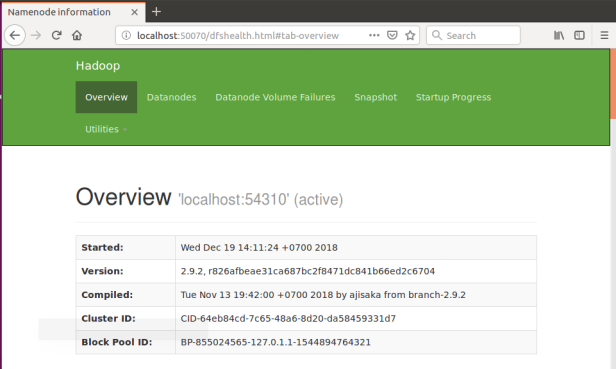

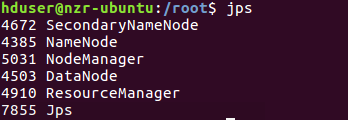

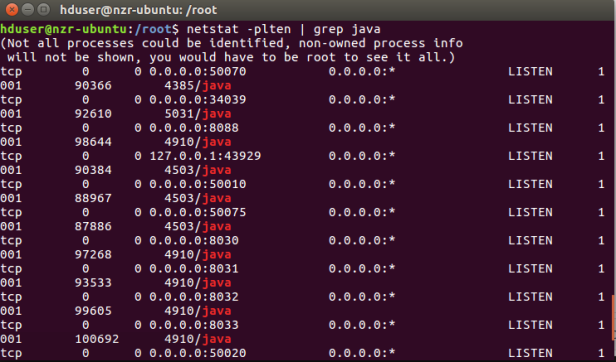

- Selanjutnya lakukan cek dengan ketik :

$ jps

$ netstat -plten | grep java

Lihat pada browser http://localhost:50070/