9. Duplikasi Ubuntu Instance

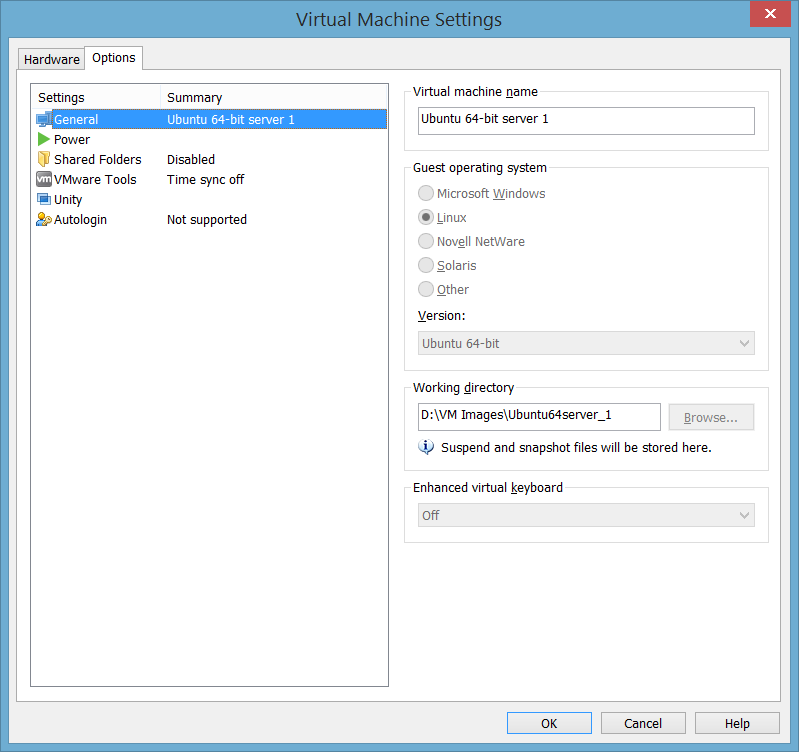

Untuk membuat 3 instance server ubuntu, shutdown VMWare, dan kopi direktori tempat file-file VM Image tersebut dua kali. Untuk mengetahui letak direktori, buka menu Player → Manage → Virtual Machine Setting di bagian Working Directory

klik browse, dan kopi direktori tempat file-file VM Image tersebut dua kali. Untuk mengetahui letak direktori, buka menu Player → Manage → Virtual Machine Setting di bagian Working Directory

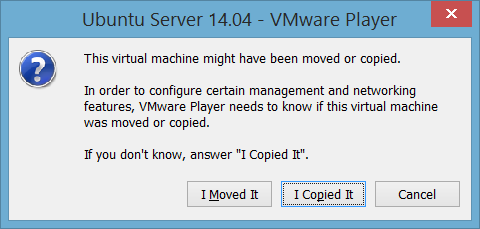

Selanjutnya, jalankan VMWare Player, pilih menu Open a Virtual Machine. Buka file .vmx di ke 2 direktori hasil copy tersebut, dan pilih Play virtual Machine. Anda akan mendapatkan dialog box

Pilih “I Copied It”.

10. Setting koneksi

Setting hostname

Buka 3 Virtual machine tersebut, ubah nama masing-masing menjadi ubuntu1, ubuntu2 dan ubuntu3, dengan cara edit file /etc/hostname :

hduser@ubuntu:~$ sudo vi /etc/hostname

Misalnya untuk server ubuntu3 menjadi sbb:

Lakukan hal serupa di 2 server yang lain. Setting Mapping Hostname

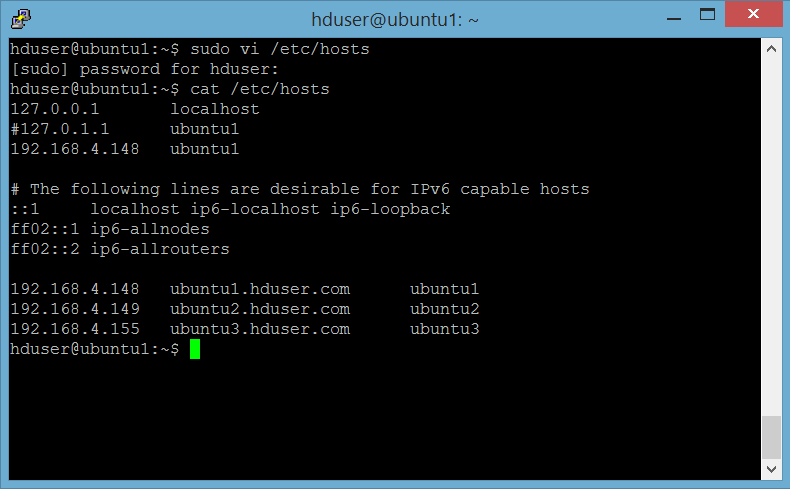

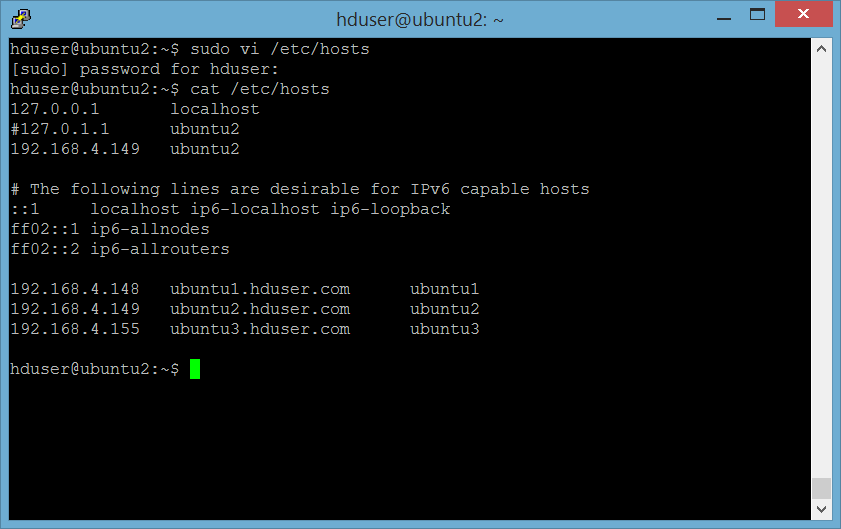

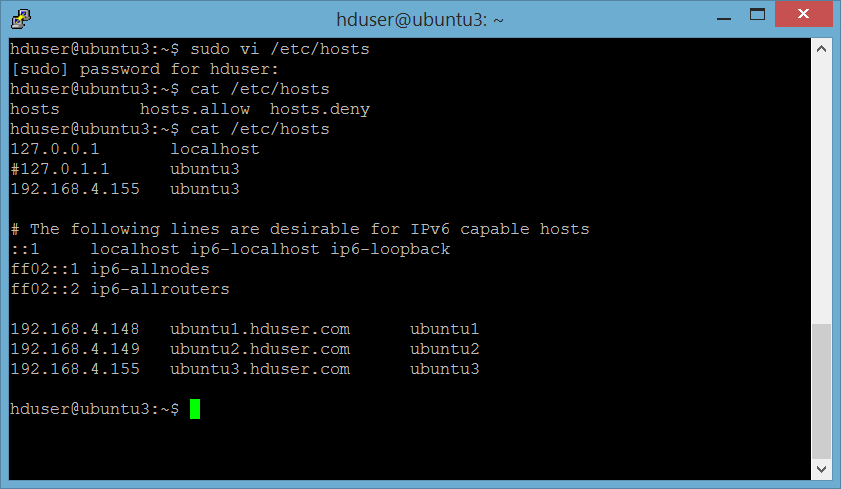

Edit file /etc/hosts di ke 3 server sbb:

Server 1 : ubuntu1

Server 2 : ubuntu2

Server 3 : ubuntu3

Untuk mengetahui IP address masing-masing server, gunakan command ifconfig.

Lakukan di ke 3 server.

Setting ssh

Di server ubuntu1, lakukan:

hduser@ubuntu1:~$ ssh-copy-id -i /home/hduser/.ssh/id_rsa.pub hduser@ubuntu2

hduser@ubuntu1:~$ ssh-copy-id -i /home/hduser/.ssh/id_rsa.pub hduser@ubuntu3

Untuk mengetes koneksi, lakukan :

hduser@ubuntu1:~$ ssh hduser@ubuntu2

hduser@ubuntu1:~$ ssh hduser@ubuntu2

Seharusnya sudah tidak diminta password untuk ssh tersebut.

Di server ubuntu2 dan ubuntu3, lakukan:

hduser@ubuntu2:~$ ssh-copy-id -i /home/hduser/.ssh/id_rsa.pub hduser@ubuntu1

Untuk mengetes koneksi, lakukan :

hduser@ubuntu2:~$ ssh hduser@ubuntu1

Seharusnya sudah tidak diminta password untuk ssh tersebut.

11. Format HDFS file system

Lakukan ini di namenode (server ubuntu1) pada pertama kali instalasi. Jangan melakukan namenode format untuk Hadoop yang sudah berjalan (berisi data), karena perintah format ini akan menghapus semua data di HDFS, dan kemungkinan akan membuat hdfs dalam cluster, hal tidak konsisten satu sama lain (namenode dan data node).

hduser@ubuntu1:$ hdfs namenode -format

Outputnya akan seperti berikut ini:

12. Start HDFS dan Yarn

Lakukan ini di namenode (server ubuntu1).

Start hdfs :

hduser@ubuntu1:$ /usr/local/hadoop/sbin/start-dfs.sh

Start yarn :

hduser@ubuntu1:$ /usr/local/hadoop/sbin/start-yarn.sh

Untuk memastikan data node sudah berjalan dengan baik, di data node server (ubuntu2 dan ubuntu3), cek log di /usr/local/hadoop/logs/hadoop-hduser-datanode-ubuntu2.log dan /usr/local/hadoop/logs/hadoop-hduser-datanode-ubuntu3.log

ika anda mendapatkan message seperti berikut ini:

2015-11-10 12:35:53,154 WARN org.apache.hadoop.hdfs.server.datanode.DataNode: Problem connecting to server: ubuntu1/192.168.4.148:54310

Maka pastikan bahwa setting /etc/hosts di ke 3 server sudah dilakukan dengan benar seperti di poin 10 di atas (Setting Koneksi). Cek ip masing-masing server dengan perintah ifconfig. Cek service di masing-masing server dengan perintah jps.

12. Test HDFS

Untuk memastikan semua node sudah naik dan berfungsi dengan baik, upload file test ke dfs. Lakukan perintah berikut ini di server name node (ubuntu1):

buat direktori /data di hdfs

hadoop fs -mkdir /data

upload file /usr/local/hadoop/README.txt

hadoop fs -put /usr/local/hadoop/README.txt /data/README.txt

13. Hadoop Web Interface

Dari keterangan di atas terlihat bahwa terdapat 2 data nodes yang hidup dan terhubung. Klik menu Datanodes untuk melihat informasi lebih detail mengenai kedua data node tersebut:

File yang dibuat tadi akan terlihat di menu Utilities → Browse the file system