Untuk menjalankan 3 buah virtual machine secara bersamaan, maka PC atau laptop yang akan digunakan harus memiliki setidaknya 8 GB RAM, dan alokasi total untuk ke 3 VM ini sebaiknya tidak melebihi 4GB.

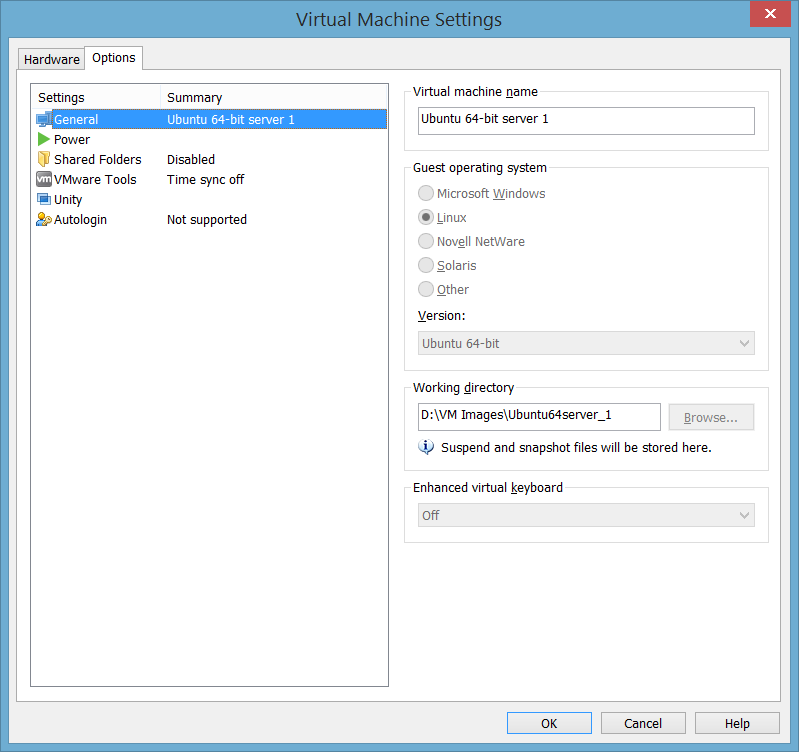

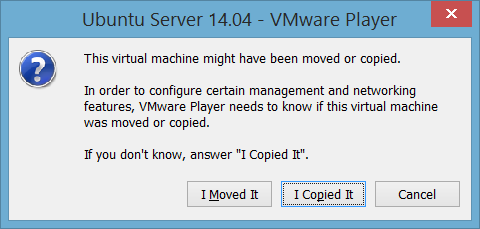

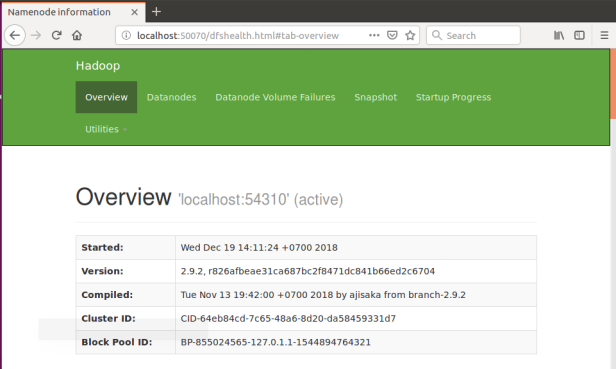

Berikut ini langkah instalasi Hadoop di Ubuntu 14.04 vmWare. Dalam tutorial ini digunakan hadoop 2.6.0. Untuk konfigurasi ini menggunakan 1 server namenode dan 2 server datanode. Yang akan dilakukan adalah menginstall 1 mesin sampai selesai, lalu copy 2 kali untuk mendapatkan 3 instance server, dan kemudian setting agar ke-3 nya dapat berkomunikasi satu sama lain.

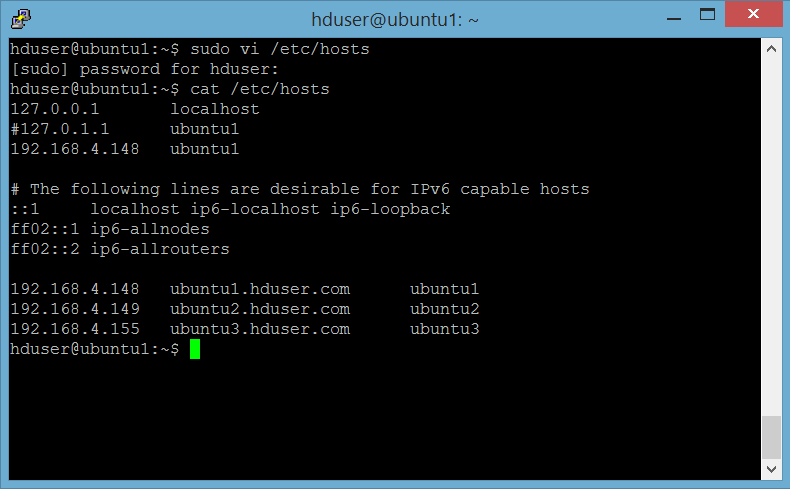

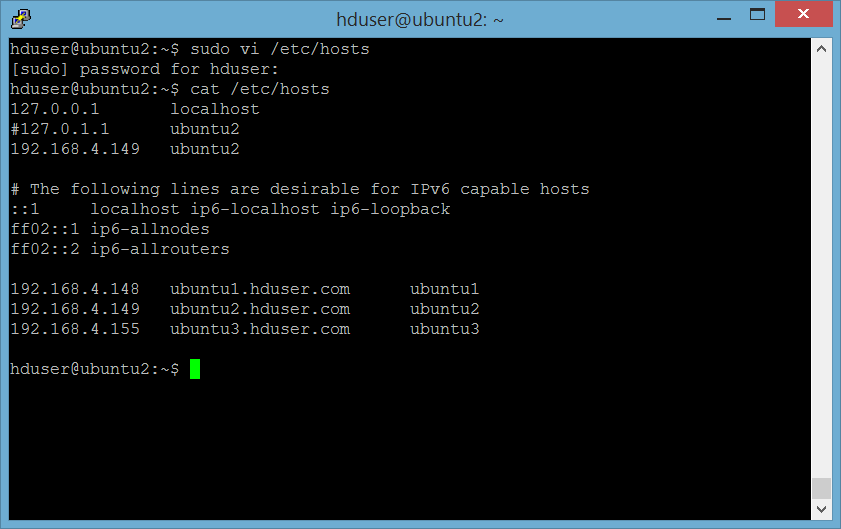

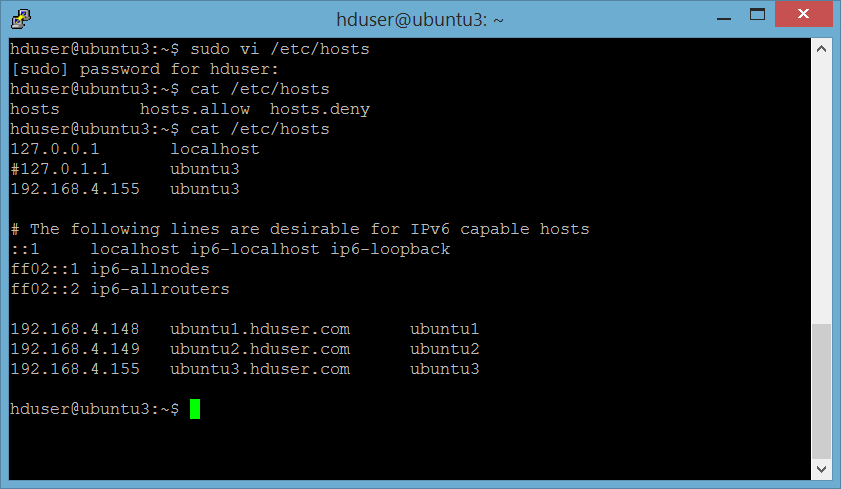

IP Type Node Hostname

192.168.4.148 Name node ubuntu1

192.168.4.149 data node 1 ubuntu2

192.168.4.155 date node 2 ubuntu3

1. Install VMWare Player

Install VMWare player, tergantung OS host yang digunakan apakah menggunakan 32bit atau 64bit : https://my.vmware.com/web/vmware/free#desktop_end_user_computing/vmware_player/6_0

2. Install Ubuntu

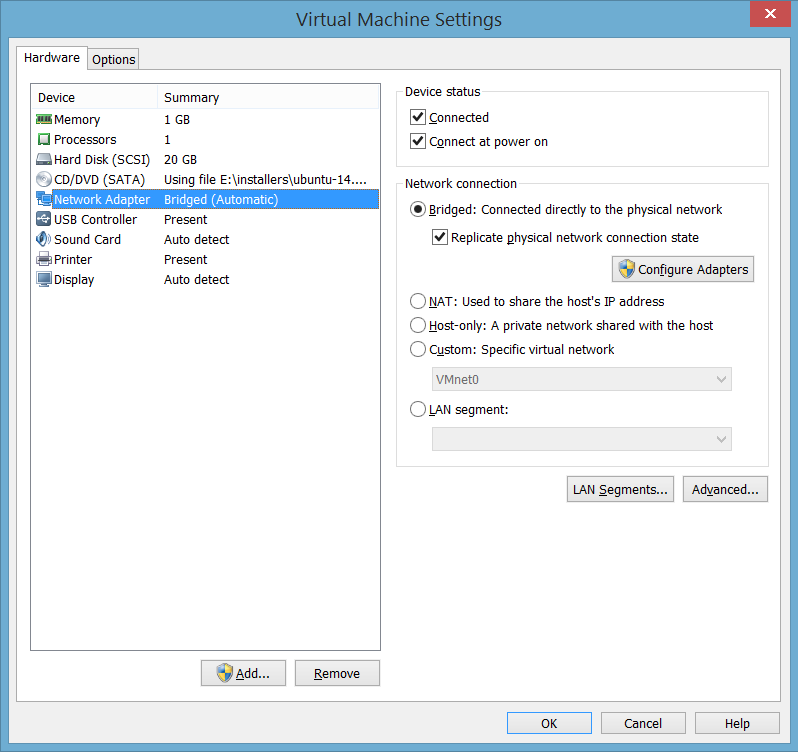

Install Ubuntu 14.04 di VMWare player,. Download iso image Ubuntu 14.04 LTS di http://releases.ubuntu.com/14.04/ (perhatikan keperluan, 32bit atau 64bit OS) Agar dapat berkomunikasi satu sama lain, termasuk dapat diakses melalui puTTY, set network setting ke Bridged

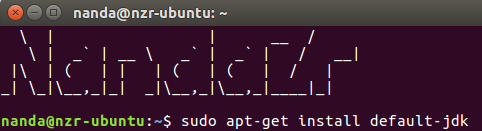

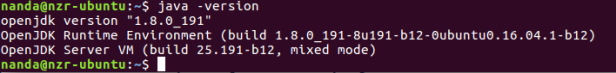

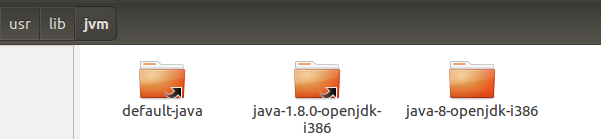

3. Install jdk

Ada beberapa pilihan yang bisa diinstall, di antaranya openjdk atau oracle jdk. Untuk open jdk pilih setidaknya openjdk 7, dengan perintah sbb:

user@ubuntu:~$ sudo apt-get install openjdk-7-jdk

Atau bisa juga menginstall jdk 7 oracle, dengan langkah sbb:

- download jdk 7 di http://www.oracle.com/technetwork/java/javase/downloads/jdk7-downloads-1880260.html , sekali lagi, perhatikan kebutuhan OS 32bit atau 64 bit

- upload ke ubuntu

- Extract package yang sudah diuplad tersebut

user@ubuntu:~$ tar xzvf jdk-7u79-linux-x64.tar.gz

- pindahkan ke direktori /usr/local/java

user@ubuntu:~$ sudo cp -Rh jdk1.7.0_79 /usr/local/java

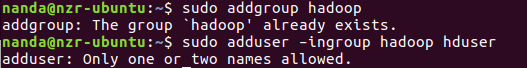

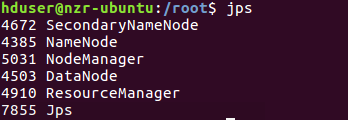

5. Create dedicated group dan user untuk hadoop

Membuat user hduser dan group hdgroup untuk menjalankan hadoop. Langkah ini tidak harus dilakukan, tapi disarankan untuk memisahkan instalasi hadoop dengan aplikasi2 lain di mesin yang sama.

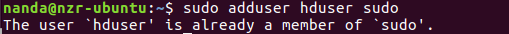

Masukkan hadoop ke dalam sudoers (untuk create direktori, set permission, dll)

user@ubuntu:~$ sudo adduser hduser sudo6. Setting jdk path Sebelumnya cek instalasi dengan perintah:

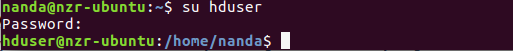

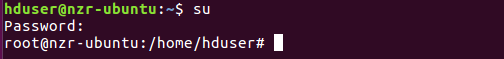

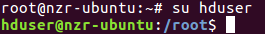

Login ke user hduser dengan perintah:

user@ubuntu:~$ su hduserSet JAVA_HOME di file .bashrc dengan memasukkan path yg sesuai, misalnya untuk java di direktori /usr/local/java , maka tambahkan baris berikut ini:

export JAVA_HOME=/usr/local/java

Apply setting dengan jalankan perintah berikut ini:

hduser@ubuntu:~$ . .bashrc7. Configure SSH

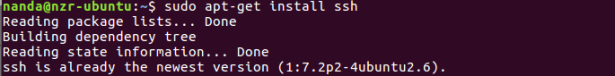

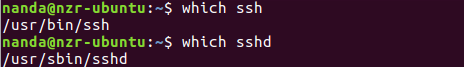

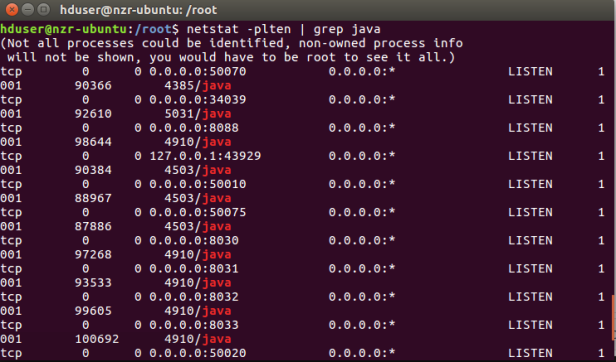

Hadoop memerlukan akses SSH untuk memanage node-node-nya. Yang perlu dilakukan konfigurasi akses SSH ke localhost untuk user hadoop yang sudah dibuat sebelumnya, dan ke data node-nya nantinya.

a. install ssh

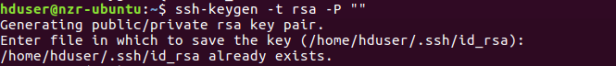

hduser@ubuntu:~$ sudo apt-get install sshb. generate an SSH key untuk user hadoop

hduser@ubuntu:~$ ssh-keygen -t rsa -P ""Perintah di atas akan membuat RSA key pair dengan password kosong. Sebenarnya penggunaan password kosong ini tidak disarankan dari sisi keamanan, namun dalam hal ini karna memerlukan akses tanpa password untuk keperluan interaksi Hadoop dengan node-node-nya.

c. enable akses SSH ke local machine dengan key yang baru dibuat

hduser@ubuntu:~$ cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keysd. test setting SSH

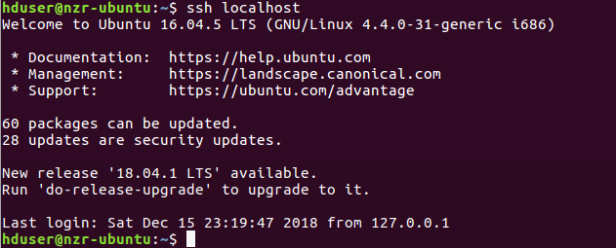

Langkah terakhir adalah testing setup SSH tersebut dengan melakukan koneksi ke localhost menggunakan user hadoop. Langkah ini juga diperlukan untuk menyimpan host key dingerprint ke file known_host milik user hadoop.

Langkah terakhir adalah testing setup SSH tersebut dengan melakukan koneksi ke localhost menggunakan user hadoop. Langkah ini juga diperlukan untuk menyimpan host key fingerprint ke file known_host milik user hadoop.

8. Instalasi Hadoop

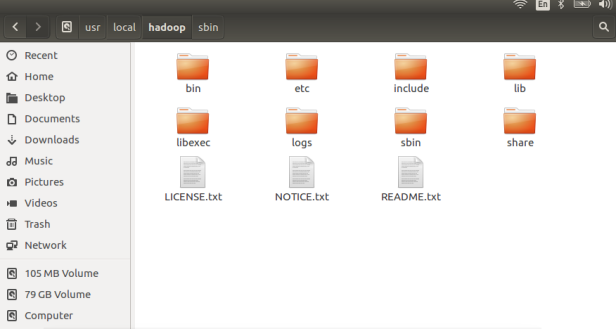

Download hadoop di https://www.apache.org/dist/hadoop/core/hadoop-2.6.0/hadoop-2.6.0.tar.gz, extract ke sebuah direktori, misalnya /usr/local/hadoop.

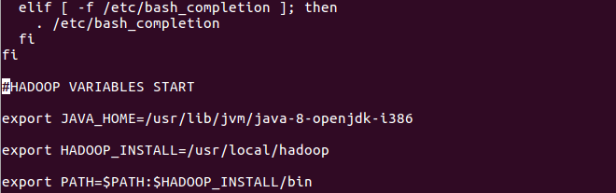

Update File .bashrc

Tambahkan baris berikut ini ke akhir file $HOME/.bashrc dari user hadoop. Jika menggunakan shell selain bash, maka perlu meng-update config file yang bersesuaian. Berikut ini setting untuk instalasi openjdk7:

Untuk instalasi java di /usr/local/java, sesuaikan setting JAVA_HOME sbb:

export JAVA_HOME=/usr/local/java

Create direktori untuk hadoop filesystem

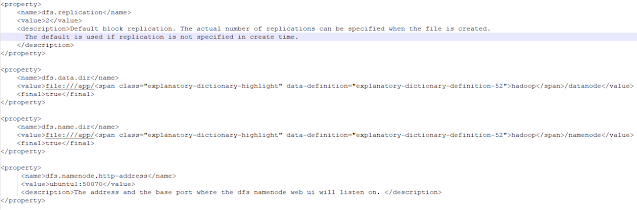

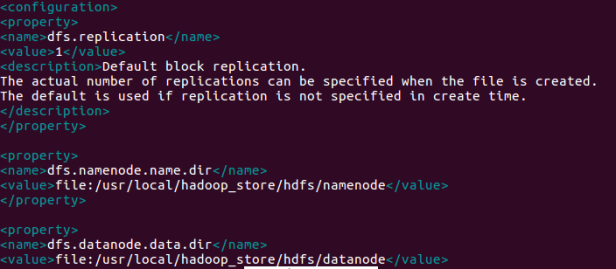

Berikut ini beberapa direktori yang perlu dibuat untuk hadoop file system, yang akan di-set dalam parameter dfs.namenode.name.dir , dfs.datanode.name.dir di file

/usr/local/hadoop/etc/hadoop/conf/hdfs-site.xml dan parameter hadoop.tmp.dir di file /usr/local/hadoop/etc/hadoop/conf/core-site.xml: /app/hadoop/namenode, /app/hadoop/datanode dan /app/hadoop/tmp

Catatan : jika langkah di atas terlewat, maka kemungkinan akan mendapatkan error permission denied atau java.io.IOException ketika anda akan memformat HDFS namenode.

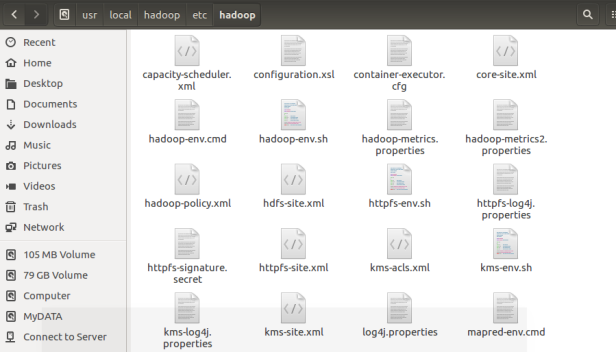

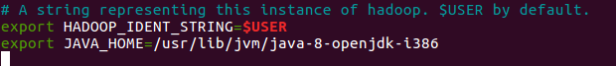

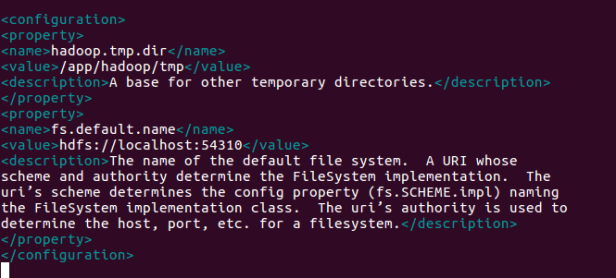

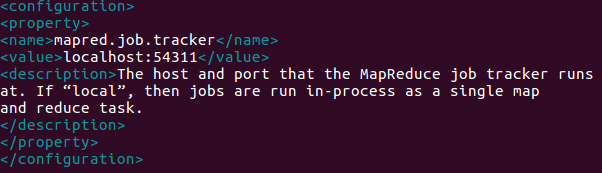

Update Hadoop File Configuration

Berikut ini beberapa file yang perlu di-update di direktori /usr/local/hadoop/etc/hadoop/etc/hadoop

a. File hadoop-env.sh

b. File-file *-site.xml

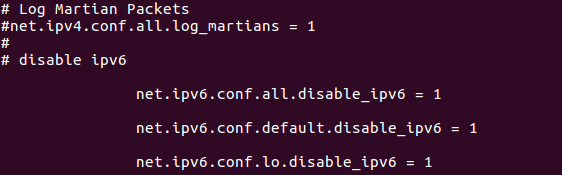

Dalam file /usr/local/hadoop/etc/hadoop/core-site.xml: